Regularziation은 머신러닝,딥러닝에서 모델이 학습 데이터에만 오버피팅되지 않도록 방지하는 기법으로 알려져 있다.

그러나 Regularziation 테크닉(weight decay의 방법인 L1, L2 Regularziation)은 오버피팅을 방지할 뿐만 아니라, human knowledge를 prior로서 반영할 수 있다. (Expressing Preferences)

L1 & L2 Regularization as Prior

결론만 이야기 하자면, L1 Regularization을 부여하는 것은 베이지안 통계학의 관점에서 가중치에 대한 사전 분포로 Laplace distribution Prior를 부여하는 것과 같다.

기존 머신러닝 관점에서의 L1 Regularization은 모델의 Loss function에 가중치의 절대값에 비례하는 항을 추가하는 것이다.

L1 Regularization의 경우 슬라이드에서 보이는 $W_1$ vector처럼 일부 영향력이 사소한 가중치를 정확히 '0'으로 만들어 모델이 피쳐의 선택(feature selection)에 유리하게 작용하도록 한다. 이러한 특징 때문에 L1 Regularzation을 Lasso(Least Absolute Shrinkage and Selection Operator)라고도 부른다.

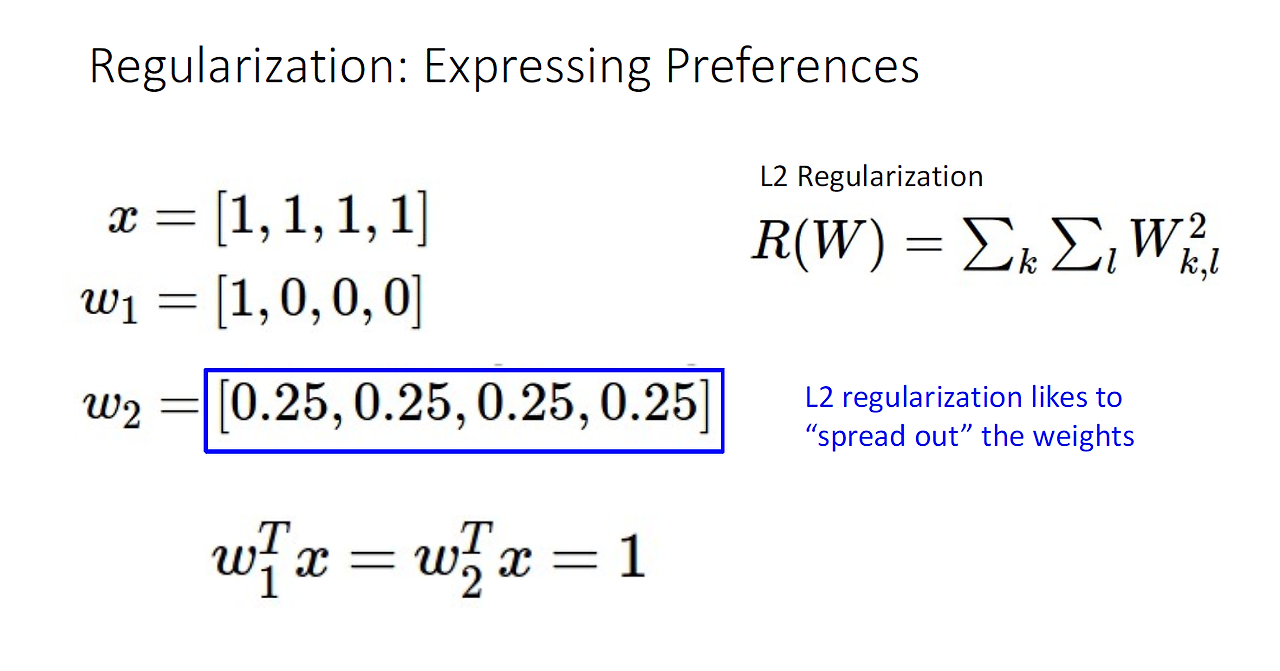

L2 Regularization 을 부여하는 것은 베이지안 통계학의 관점에서 가중치에 대한 사전 분포로 Gaussian distribution Prior를 부여하는 것과 같다. Guassian prior를 가정하는 것은 슬라이드와 같이 weight의 분포를 "speard out"하는데 초점을 맞추는 것과 같다. 즉, $W_2$ vector처럼 모든 가중치가 동등한 정도로 퍼지게 만든다.

Applications

다수의 변수(feature)가 포함된 데이터에서 선형회귀 모델의 변수 선택이 필요하거나, 비교적 얕은 신경망의 구조에서 베이지안 딥러닝을 적용할 때 원활한 학습을 위해서 prior의 중요도는 더 커지게 된다.

regularization의 추가와 prior에 대한 가정과 동등한 이유에 대해서는 수식적으로 서술된 아래의 Reference에서 참고할 수 있다.

Reference

https://putama.github.io/posts/2018/08/L2-regularization-bayesian/

'기초 노트 > DataScience' 카테고리의 다른 글

| 가중치 양수 제한 방법, 수치적 안정성 부여 방법 (0) | 2025.03.14 |

|---|---|

| Concept Drift vs Covariate Shift (2) | 2024.09.01 |

| 선형회귀 분석에서 로그 변환을 취하는 이유 (0) | 2024.03.14 |

| 선형회귀의 4가지 기본 가정 (0) | 2024.03.11 |

| 데이터의 Cardinality란 무엇인가? (2) | 2024.03.07 |