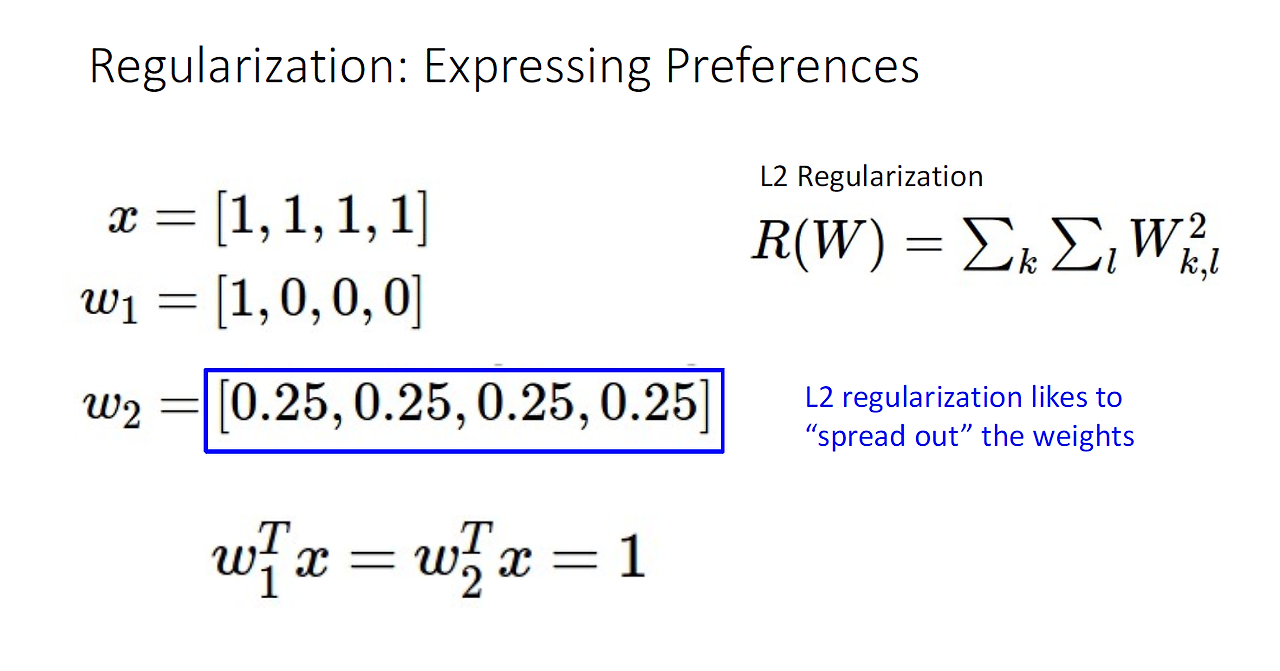

이번 강의 주제는 드디어 Neural Networks(신경망)이다. 지금 까지 배운 내용에 대한 요약이다. 1. 먼저 우리는 knn과 같은 non-parametric classifier가 아닌, parametric classifier를 만들기 위해서 Linear model에 대해서 다뤘다. 2. 다양한 weight의 세팅에 대해서 우리의 happiness or unhappiess를 표현하기 위한 수단인 loss function에 대해서 다뤘다. 3. 그 다음 weight를 업데이트 하는 방법인 Iterative method - gradient descent의 변형들 (SGD+momentum 그리고 Adam , RMSProp) 등의 optimization에 대해서 배웠다. 우리는 다시 1번에서 등장한 Li..